远方的地平线总是模糊不清,细节被距离和雾气遮蔽。这正是预测未来如此困难的原因:我们无法看清前方事物的轮廓,只能做出有根据的推测。

最新发布的《AI 2027》报告由一支来自OpenAI和人工智能政策中心等机构的研究团队撰写,对未来2至3年的人工智能发展做出了详细预测,包括具体的技术里程碑。由于时间跨度较短,这份报告对近期AI发展的描述尤为清晰。

基于广泛的专家反馈和情景规划,《AI 2027》按季度预测了AI能力的进展,尤其是多模态模型将实现高级推理和自主性。这份预测的独特之处在于其具体性以及作者团队的可信度——他们直接接触当前的研究管道。

最引人注目的预测是:人工通用智能(AGI)将在2027年实现,而人工超级智能(ASI)将在数月后出现。AGI将在几乎所有认知任务上达到或超越人类水平,包括科学研究与创造性工作,同时展现适应性、常识推理和自我改进能力。ASI则更进一步,其解决问题的能力将远超人类理解范围。

与许多预测一样,这些结论基于假设,尤其是AI模型和应用将继续保持过去几年的指数级进步。虽然这种趋势是合理的,但并非必然,因为模型的扩展可能已面临收益递减。

并非所有人都认同这些预测。艾伦人工智能研究所CEO阿里·法哈迪对《纽约时报》表示:“我支持预测,但这份报告缺乏科学依据,也不符合AI领域的实际发展。”然而,Anthropic联合创始人杰克·克拉克在其《Import AI》简报中称,这是“对‘指数级生活’最精彩的预演”,并认为其“技术洞察力极强”。Anthropic CEO达里奥·阿莫迪也提出类似时间表,认为“全能型AI”将在2至3年内出现。谷歌DeepMind则在新论文中提出,AGI可能在2030年前实现。

大加速时代:史无前例的颠覆

这似乎是一个关键节点。历史上曾有过类似时刻,如印刷术和电力的发明。但那些技术进步需要数十年才能产生显著影响。

AGI的到来则截然不同,且可能令人恐惧——尤其是如果它迫在眉睫。《AI 2027》描述了一种情景:由于与人类价值观错位,超级智能AI可能导致人类灭绝。若预测准确,人类面临的最大风险可能与你下次手机升级的时间近在咫尺。谷歌DeepMind的论文也指出,人类灭绝是AGI的可能结果之一(尽管他们认为概率较低)。

托马斯·库恩在《科学革命的结构》中提出:观念转变往往需要压倒性证据。而AI领域的转变可能已经开始。

未来已近在眼前

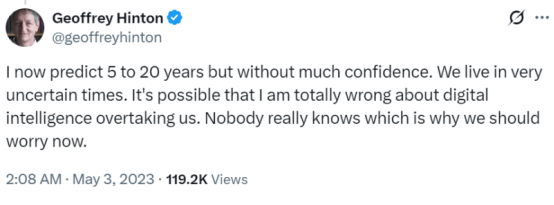

在大语言模型(LLMs)和ChatGPT出现前,专家对AGI的预测中位数是2058年。“AI教父”图灵奖得主杰弗里·辛顿曾认为AGI还需“30到50年甚至更久”。但LLMs的进展让他改变观点,认为可能2028年就会实现。

如果AGI在未来几年内出现并快速演进为ASI,人类将面临深远影响。《财富》杂志的杰里米·卡恩指出,AGI可能导致“大规模失业”,因为企业会倾向于自动化岗位。两年的适应期对个人和企业远远不够——客服、内容创作、编程和数据分析等行业可能在培训体系完善前就被颠覆。若叠加经济衰退,企业削减人力成本的压力将更甚。

“我思故我在”……AI亦然?

即使AGI未引发失业或灭绝危机,仍存在更深层问题。自理性时代以来,人类存在的意义始终与“思考”绑定。

笛卡尔在163年提出的“我思故我在”(Cogito, ergo sum)奠定了现代人文主义、科学方法乃至民主制度的基础。人类作为思考者成为现代世界的核心。

这引出一个根本问题:当机器能够(或看似能够)思考,而我们又将思考外包给AI时,现代“自我”概念将如何定义?微软研究发现,过度依赖生成式AI会导致批判性思维减少,长期可能“损害本应保留的认知能力”。

前路何在?

如果AGI真的即将到来,我们不仅要应对其对就业和安全的影响,更要重新审视“人类为何存在”。与此同时,也必须认识到AI在加速科学发现、减轻痛苦和扩展人类能力方面的巨大潜力。例如阿莫迪所言,“强大AI”可能将百年生物学研究压缩至5-10年,推动医疗等领域飞跃。

《AI 2027》的预测未必准确,但其合理性与警示性已足够。作为能动的个体和社会成员,我们必须立即行动:企业需投资AI安全研究与组织韧性;政府应加快建立兼顾当下评估与长期风险的监管框架;个人则要聚焦创造力、情商和复杂判断力等人类特质,与AI建立健康协作关系。

关于遥远未来的抽象辩论已经结束——为近在眼前的变革做好具体准备,才是当务之急。我们的未来不会由算法独写,而取决于今天的选择与坚守的价值观。

精选文章: