这篇文章可以让大家更好的了解AI绘画如何发展到今天的,作为一个科普文,里面不涉及任何高深的技术点。

AI生成绘画本来是一个特别小众的领域,但是在今年越来越多圈子外的人都已经开始了解和使用它。那么今天我想带大家一起回顾一下AI绘画是如何开始的,又是怎么在今年突然出圈?

我们几乎每个人都会说话,但是只有极少数的一部分人会画画,我们管这一小部分会画画的人叫画师。画画在大家眼里是一件需要天赋和长期艰苦训练的事情,很多人从小就接受美术训练,花了长达7~8年的时间可能才可以达到一个及格的水平。

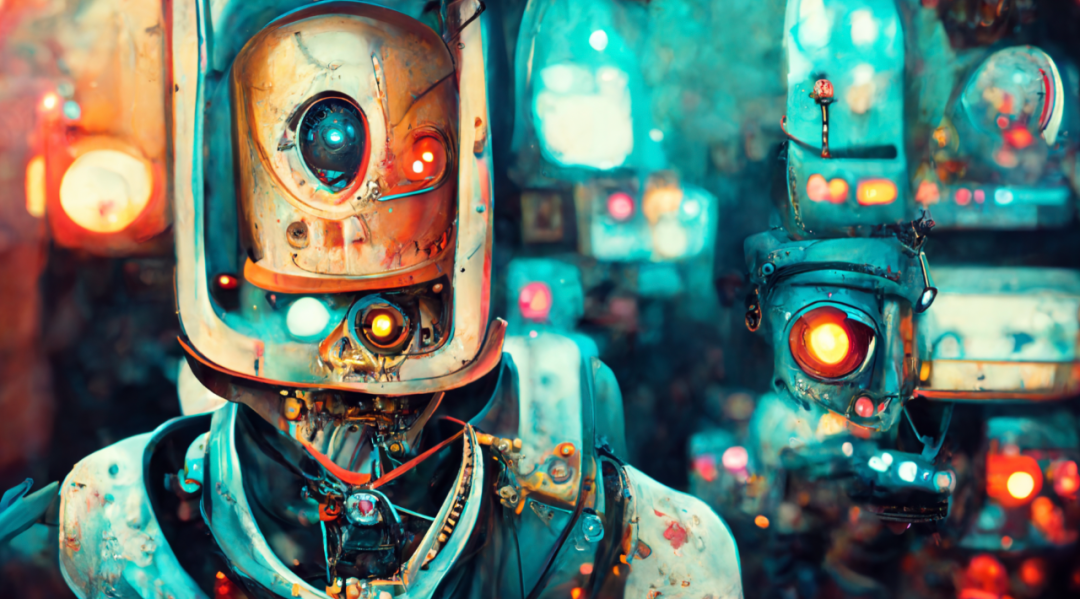

用midjouney生成的蒸汽朋克猫咪

缘起:2015年 用文字画画

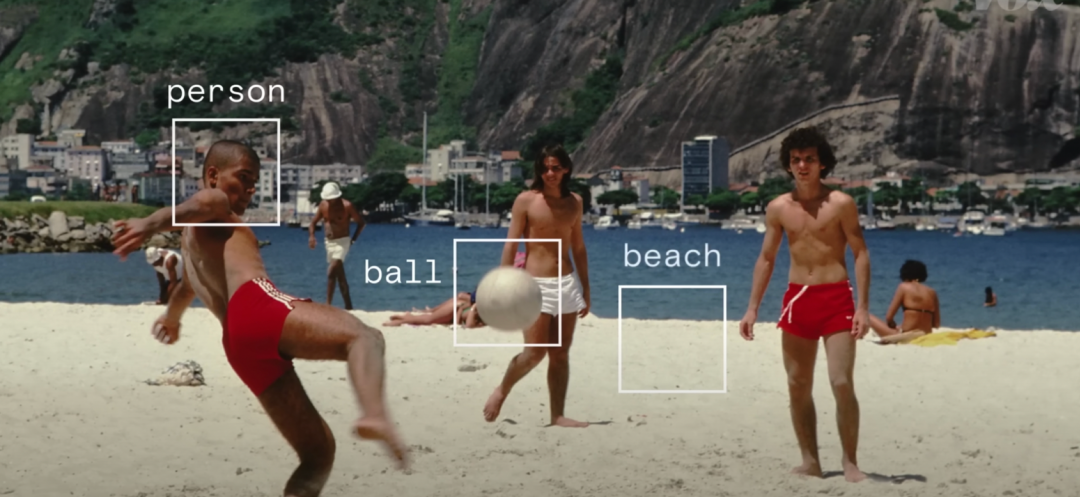

这件事的源头得从7年前,2015年开始说起,那一年出了一项人工智能的重大进展——智能图像识别。机器学习可以标记图像中的对象,然后他们还学会了将这些标签放入自然语言描述中去。

这件事让一组研究员产生了好奇。如果把这个过程翻转过来会怎么样?

我们可以把图像转换成文字,那么我们是否同样可以把文字转换成图像?

这是一项异常艰巨的工作,它跟你从搜索引擎上用文字搜索图像完全不一样。他们希望用文字去生成那些这个世界上没有的图像。

于是他们向计算机模型询问了一些他们从未见过的东西。举个例子,你见过的所有的校车都是黄色的,那么如果你写红色或者绿色的校车,它真的会尝试生成绿色么?它真的做到了。

这是一个32X32像素的小图片,糊的你几乎分辨不出来这是什么东西,但是这是一切的开始。这些研究人员在2016年的论文显示了未来的无限可能。

而现在未来已来。

2021年 Dalle 与 开源社区的程序员们

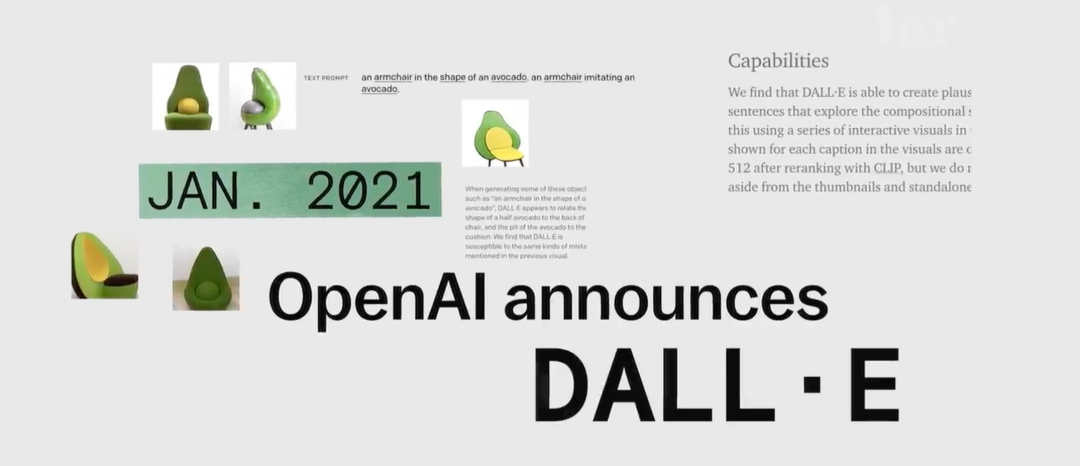

openAI与它并不open的Dalle

让我们把时间倒回去一年,回到2021年一月。一家叫openAI的人工智能公司宣布了dalle,他们声称可以从任何文字中创建图像。他们今年4月公布了dalle2,生成的图像更加的逼真和精确了。而且还可以对这些图像进行无缝编辑。

但是openai一直都没有公开dalle的算法和模型。直到现在,哪怕dalle2都开始商用了,它的限制仍然很多。

AI开源社区

所以在过去的一年里,一个由独立开发人员组成的开源社区,根据现有的所有已知的技术模型,做了各种各样的开源文本图像生成器。

在这个时期我把它称之为colab时期,这些免费开源的生成器都需要你在google colab上才可以使用,需要一定程度的代码知识,而且生成的图像还非常的抽象,像素也比较低。我周围也有几个朋友在21年开始玩AI绘画,但是都局限在非常非常小的圈子。

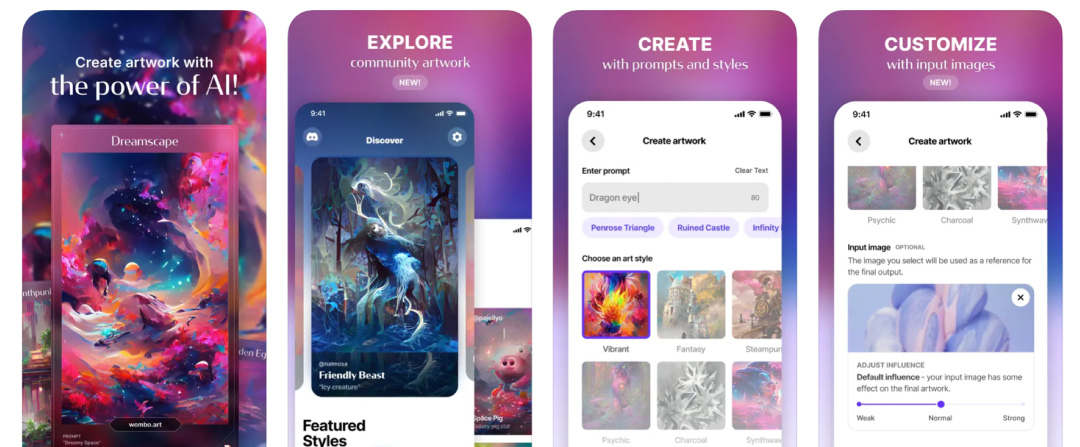

2021年11月的时候一款叫dream by wombo的APP出现了,它把AI的生成器封装到了APP里,这个举动让所有人都可以零学习成本的使用它。所以它从2021年底一直从国外火到了国内。

但是因为模型算法的局限性,它生成的图像质量还是比较低的,但是已经引起了大家的好奇心。

2022年:AI绘画程序爆炸式增长

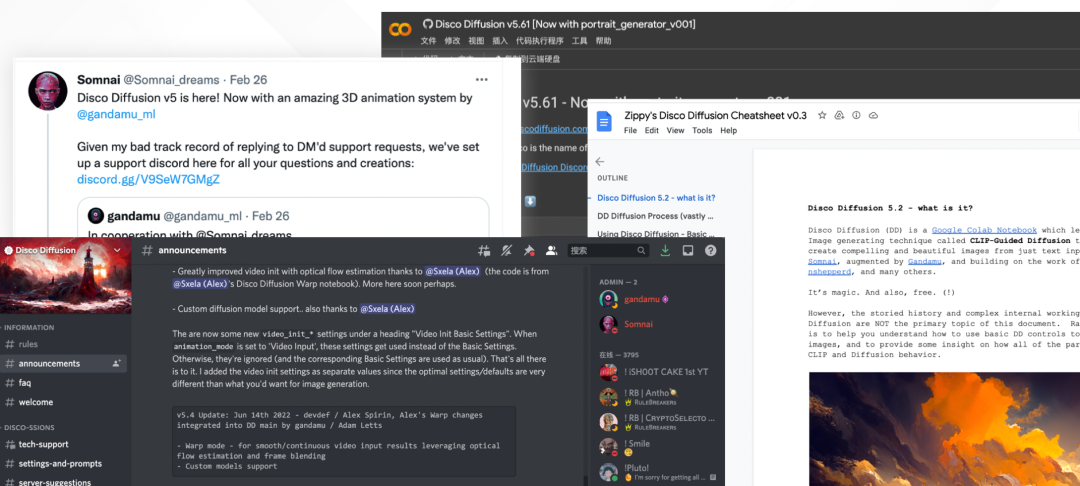

在2022年的2月,由somnai等几个开源社区的工程师做了一款叫disco diffusion的AI图像生成器。从这款图像生成器开始,AI绘画得到了质的飞跃。而且它建立了完善的帮助文档和社群,disco diffusion本身也拥有非常完善强大的功能。

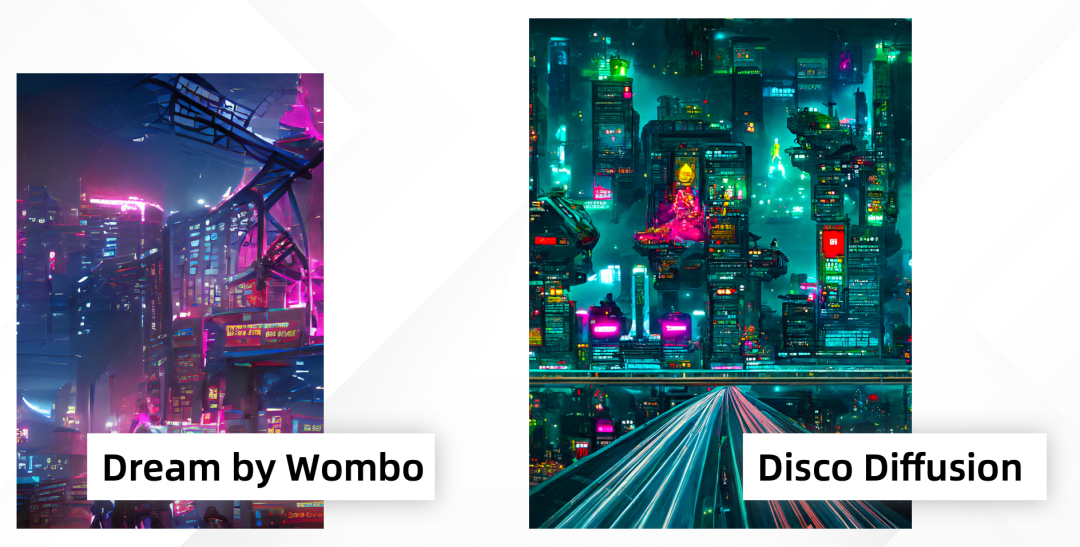

同样是赛博朋克城市的提示词,DD与dream的对比

3月国内开始出现disco diffusion的教程,随着这些教程的不断完善完善。越来越多的人开始使用disco diffusion创作作品,但是DD有一个致命的缺点就是它生成的画面都十分的抽象,这些画面用来生成大场景和抽象画还不错,但是几乎无法生成具象的人或者物。

3月 midjouney

这个时候一款叫midjouney的AI绘画生成工具出现了。

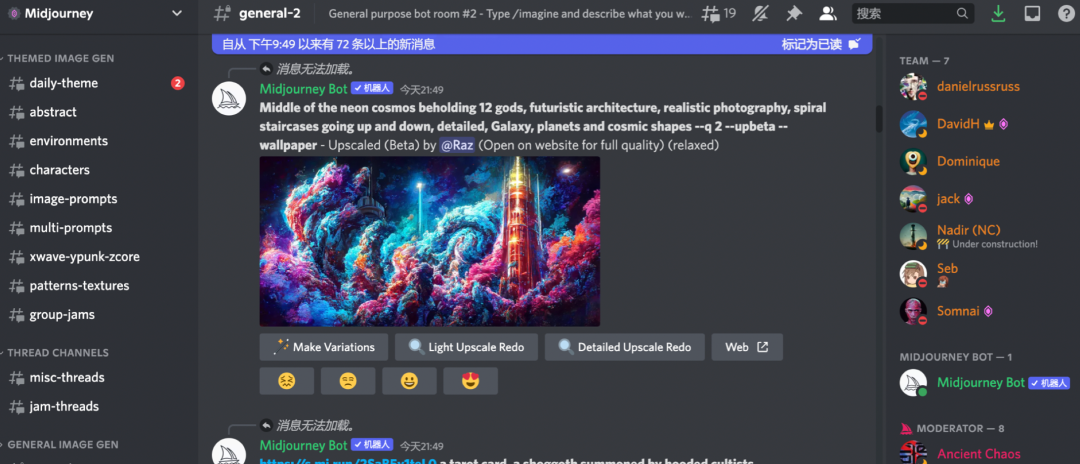

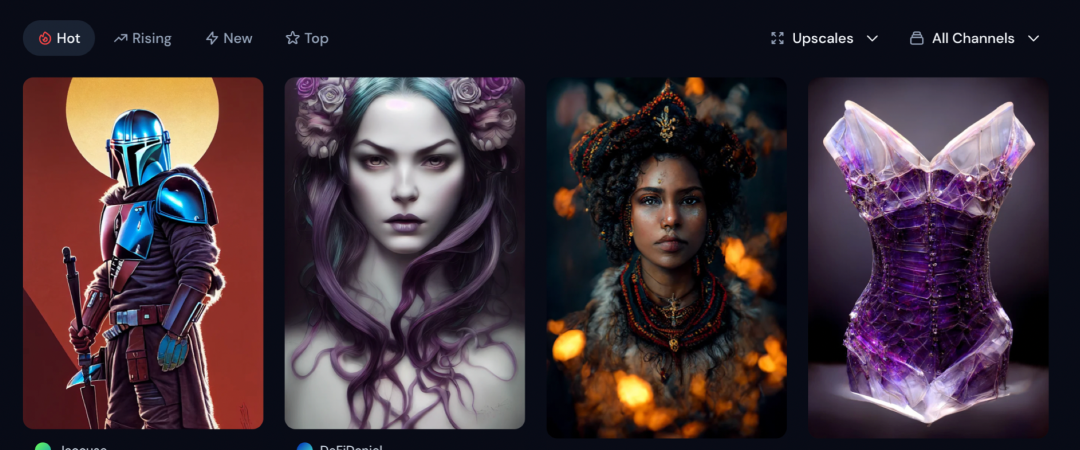

3月14日,mid开始内测,这是一款由disco diffusion的核心开放人员参与开发的AI生成器,mid与dd不同,它是一款搭载在discord上的聊天机器人程序,不需要之前繁琐的操作,也没有DD十分复杂的参数调节,你只需要向mid输入文字就可以生成图像。而且mid的模型更加的精准,dd只能生成抽象的风景,但是mid在人像上也能表现的比较好。

而且midjouney最大的优势其实并不是它的生成效果多么优秀,而是在于它是一个社区形式的产品。跟DD每个人都是独立创作不同,在mid上所有人的作品都是公开的,你用的提示词和相关的作品都是对社区里所有人可见的,你再也不需要问其他人这幅画用了什么提示词?这个特性让社区每天都不断的涌现越来越多优秀的作品和创意,每个人都可以尽情的学习他人的作品。

我把它称之为养蛊式创作。

4月 Dalle2

4月10日,dalle2开始内测,dalle2可以生成非常精确复合逻辑的图像。它还可以根据提示词来重新修改编辑你的图片。

dalle2的跟之前的AI生成器都不同,无论是DD还是mid,我们都是可以看出是AI生成的,dalle2的生成图你已经无法跟人类的作品做区分了。

这是我用dalle2创作的画,是由左边的提示词直接生成的。如果我不做说明,这幅画跟正常的人类作品几乎没有区别。

它还可以直接生成非常有质感的3D图像,这是我用dalle2直接生成的3D金属质感的十二生肖图标。

它还可自动补充无限拓展图像,所以特别适合用来生成无限流动画。类似这种。

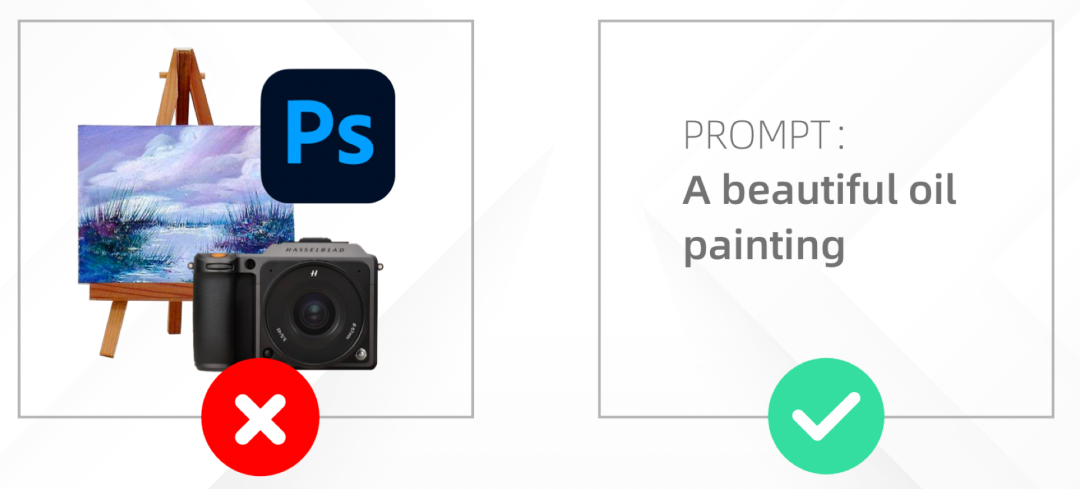

看到这里大家可能觉得dalle2已经很完美了,但是其实直到今天,dalle2的相关技术都是对公众封闭的,而且dalle2的使用也需要申请,而且通过率很低。dalle2的研发人员觉得他们做了一款很可能用来作恶的工具,所以它设置了非常多的限制,死亡,色情,人脸,暴力,公众的人物等等都是禁止在dalle2上使用的。

跟openai这个名字不同,dalle2一点都不open。

dalle2的担忧是多余的么?不是的,这个工具确实非常可怕,不法分子可以利用它来轻松生成各种各样的假图片。但是历史的车轮会因为dalle2的这些限制停下来么?

7月 Stable diffusion

7月29日 一款叫 SD的AI生成器开始内测,它可以生成媲美dalle2的精确度的图像。共分 4 波邀请了 15000 名用户参与了内测。只用了十天它的活跃数据已经到了每天一千七百万张。

SD的背后是一家英国的人工智能方案提供商,它的slogan就是“ai by the people,for the people”。跟dalle2的封闭不一样,这家公司十分推崇开源。

所以在8月22号,他们内测刚开始二十多天,SD正式宣布开源,这意味着所有人都通过它开源的技术,在本地使用SD生成自己想要的图像。SD开源属性让它在短短的一个月跟各种各样的工具结合。甚至mid也使用了开源的sd模型,并且得到了巨大的反响,这个功能只内测了24小时,但是是目前mid社区里呼声最大的。24小时里mid结合SD生成了大量的作品。

国外艺术家用SD生成的画作,艺术效果上已经超越了dalle

除此之外它还被做成了figma和ps的插件,在figma的插件里你只需要简单的画出草图,就能根据文字生成非常完整的设计稿。在ps里面你可以无缝拼接补完图像。可以说现在的SD把前面所有的AI生成工具的功能全部结合到了一起,然后还把它开源了。

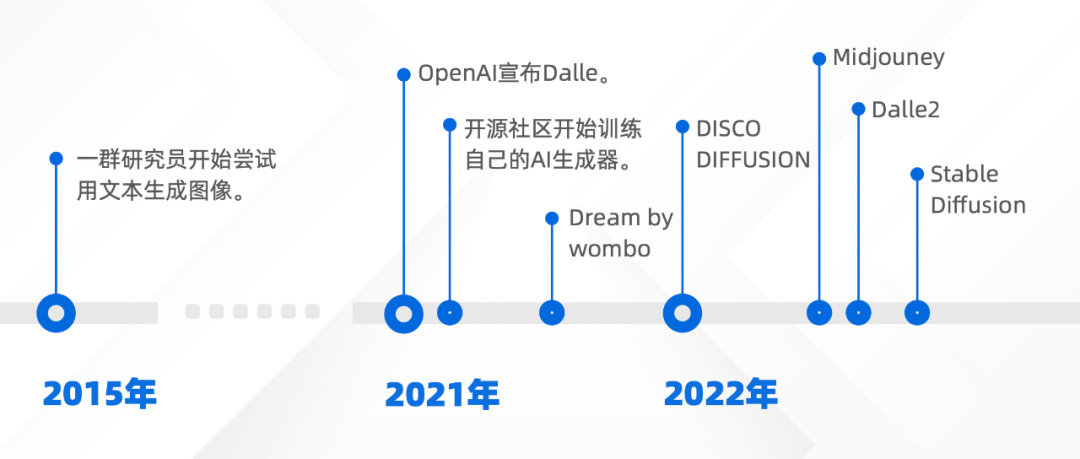

AI绘画发展时间线

现在,我们来回顾一下这一切,2015年的时候,一群好奇的工程师,把图像识别生成文字这个过程翻转过来了,他们生成了最开始的32像素的小图片,在经过了漫长的六年的缓慢发展后,2021年openai和一群开源工程师分别用他们自己的方式完善算法和模型。到了今年2022年,这个技术突然就爆发了,对于国内的大部分接触AI绘画人来说只有短短的四个月,这四个月里发生了mid内测,mid公测,dalle2内测,dalle2商用,sd内测,sd开源等等,还有无数的AI绘画小工具。

哪怕是像和菜头这样完全绘画圈外的人也在不断的讨论和使用AI绘画的功能。

很多创意相关的人已经开始用AI辅助了,我的一个朋友说,他的老板让他不要对外说他们的工作中加入了AI辅助。

“不要跟别人说我们的工作中使用了AI辅助。”

现在已经有大量的创意人和公司在使用AI绘画辅助,但是他们又不希望有太多的人知道。还有大量的创意与艺术行业的从业者内心十分抵触这项技术,觉得它根本就不应该出现。在8月15号就发生过一件非常有趣的事件,SD的推特账号突然挂了,因为被大量艺术家举报,SD的创始人在社群里表达了他对这件事的看法,他说:他们在嫉妒AI画的比他们好。不过这件事最后被证实为乌龙,因为这个账号其实只是个粉丝账号,并不是官方账号。

历史的车轮呼啸而过,是选择跳上这辆车,还是停留在原地,都是个人的选择。但是无论你是否参与,它都不会因为你的看法而停下来。

内容经授权转载自公众号“非科班设计”

精选文章:

非特殊说明,本文版权归原作者所有,转载请注明出处:大作网