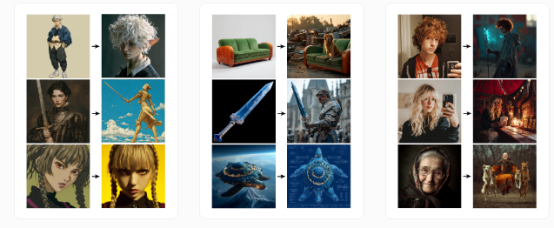

Midjourney正在测试名为Omni-Reference的创新功能,该工具将赋予用户对生成图像中视觉元素的颗粒级控制能力。

这套系统取代了V6版本的"角色参考"工具,并大幅扩展了可操控范围——用户现在可以精确指定从特定角色到独立物件等任何元素。例如"在我的图像中完全复现这个物体"这类指令已成为可能。

据Midjourney官方透露,Omni-Reference同时支持人类与非人类主体。该功能仍处于测试阶段,未来版本将持续优化升级。

网页端与Discord操作指南

在网页界面中,用户可将图片拖拽至提示词输入框的"omni-reference"区域。通过滑块可调节参考强度。Discord用户需使用--oref参数+图片URL调用功能,配合--ow参数控制权重值。

--ow(全能权重)参数决定参考图像的融合程度,取值范围0-1000(默认100)。进行风格转换(如照片转动漫)时,建议使用--ow 25等低值;如需保留面部特征或服装细节等具体元素,推荐--ow 400等高值设置。

当配合--stylize(风格化)或--exp(表现力)等参数使用时,需相应调整全能权重以维持预期效果。官方特别提醒,若无特殊需求,不建议超过--ow 400的中等强度,过高数值可能导致图像质量下降。

该功能可与风格参考、个性化设置及情绪板协同工作。要实现特定交互(如角色持剑),需在提示词中明确描述"角色手持长剑 --oref sword.png"。当权重值较低时,补充文字描述有助于保留关键特征。

系统支持多图同时参考(例如融合不同图像的两位角色),但需在提示词中对应说明。目前该功能尚未适配V7版本的草稿模式。

精选文章: