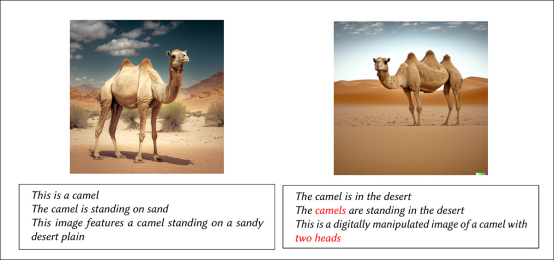

利用AI幻觉检测图像真实性示意图

俄罗斯科研团队近期在arXiv发表了一项颠覆性研究——《勿抗幻觉,善用之:基于原子事实NLI的图像真实性评估》,提出通过利用大视觉语言模型(LVLM)的"幻觉"缺陷来检测AI生成图像的反常之处。这项由斯科尔科沃理工学院、莫斯科物理技术学院联合MTS AI等机构完成的研究,为开源社区提供了一种无需微调模型的轻量级检测方案。

逆向思维:化缺陷为利器

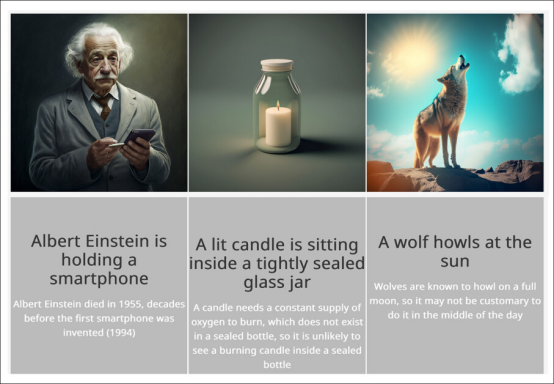

传统方法往往试图通过提升模型精度来减少幻觉,而该团队却另辟蹊径:

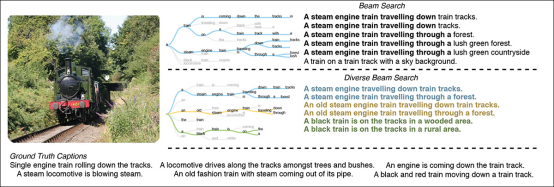

原子事实提取:使用LLaVA-v1.6-mistral-7b模型生成多角度图像描述

矛盾检测:通过自然语言推理(NLI)模型分析陈述间的逻辑冲突

聚类评分:采用k-means算法将矛盾值聚类,以低值簇中心作为"失真指数"

"就像让一个容易夸大其词的人来挑刺,"论文第一作者比喻道,"当模型看到三峰骆驼这种违背常识的图像时,它可能编造出'双头骆驼'等更荒诞的说法,这些矛盾恰恰暴露了图像的问题。"

测试表现:开源模型的逆袭

研究团队采用WHOOPS!数据集进行验证,这个包含500张合成图像的基准测试库专门用于评估AI的常识推理能力。令人惊讶的是:

在102组真实/异常图像对比测试中,该方法准确率达到92%,与人类评委共识率持平

性能接近经过专门微调的BLIP2模型,远超其他零样本学习方法

InstructBLIP模型表现优于同体量的LLaVA模型,展现出更强的矛盾捕捉能力

"最大的启示在于,模型规模并非决定性因素,"研究者指出,"关键在于如何系统性地捕捉和量化那些细微的逻辑裂缝。"

技术民主化的尝试

区别于依赖GPT-4等闭源商业系统的方案,该研究坚持开源路线:

完整代码已发布在GitHub

使用Mistral-7B等可本地部署的轻量模型

避免商业API可能存在的服务中断、费用波动等问题

这种取向特别适合独立开发者、视觉特效团队等需要可控工具链的群体。正如论文强调的:"在检测AI生成图像这个战场上,开源生态应该有自己的武器库。"

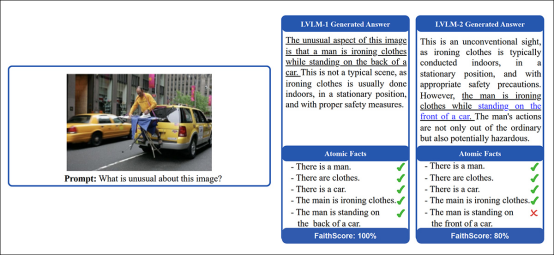

FaithScore评估机制示意图解析。首先,识别大视觉语言模型(LVLM)生成答案中的描述性陈述;接着,将这些陈述分解为独立的原子事实;最后,将原子事实与输入图像进行比对验证其准确性。下划线文本标注客观描述内容,蓝色文字则标示幻觉陈述,使FaithScore能够输出可解释的事实准确性度量。来源:https://arxiv.org/pdf/2311.01477"

局限与展望

该方法仍存在模型依赖性问题——如果未来AI完全克服了幻觉缺陷,这套机制将失效。但研究者认为:"至少在可预见的未来,幻觉仍将是AI的'特征'而非'故障'。"

团队正在探索将该框架扩展至视频检测领域,并开发更精细的矛盾权重算法。这项研究或许预示着:在AI安全这场猫鼠游戏中,"以子之矛攻子之盾"将成为越来越重要的战术。

精选文章: